¿La IA es buena o mala, y quién decide?

La implementación de la IA avanza más rápido que el marco ético necesario para controlarla.

Uno de los historiadores de la tecnología más citados, el profesor Melvin Kranzberg, fue uno de los principales defensores de la ley de las consecuencias no deseadas. Mucho se vuelve obvio en su artículo original de 1986, en el punto en el que amplía la forma en que acuñó la primera de sus propias Leyes de la Tecnología.

“Quiero decir que la interacción de la tecnología con la ecología social es tal que los desarrollos técnicos con frecuencia tienen consecuencias ambientales, sociales y humanas que van mucho más allá del propósito inmediato de los dispositivos técnicos y las prácticas mismas, y la misma tecnología puede tener resultados bastante diferentes cuando se introduce en diferentes contextos o en diferentes circunstancias «.

Yendo más allá, Kranzberg observó que muchos problemas relacionados con la tecnología surgen cuando se introducen tecnologías «aparentemente benignas» a gran escala.

Kranzberg murió en 1995 y, para él en su época, un ejemplo de este fenómeno fue el DDT: en un contexto, un pesticida con efectos secundarios peligrosos; en otro, un arma importante para frenar la propagación de la malaria. Es fácil ver por qué su pensamiento está siendo revisado hoy para abordar y explicar las preocupaciones sobre las redes sociales y, cada vez más, el impacto potencial de las formas ubicuas o casi ubicuas de inteligencia artificial (IA).

Para la IA en particular, se cree que la Primera Ley de Kranzberg proporciona algunas de las bases para la creación de una infraestructura ética en torno a la cual se puede construir la regulación y, cuando eso no sea práctico, un conjunto de costumbres y prácticas de referencia. Destaca claramente los dilemas que deben resolverse en el corazón de lo que incluso los activistas ven como una tecnología potencialmente positiva y transformadora.

El despliegue «a escala» de una serie de tecnologías basadas en IA ya ha suscitado preocupaciones que son fundamentalmente éticas.

Infamemente, el lado oscuro de Twitter fue capaz de convertir Tai, el chatbot de aprendizaje automático de Microsoft, en un vehículo para el fango racista al día siguiente de su lanzamiento en 2016.

Hace tres años, YouTube intentó que la inteligencia artificial se ocupara del problema de las redes sociales que es la moderación de contenido, solo para que su sistema elimine y restrinja el contenido publicado por organizaciones de noticias legítimas, así como las noticias falsas y la propaganda mentirosa.

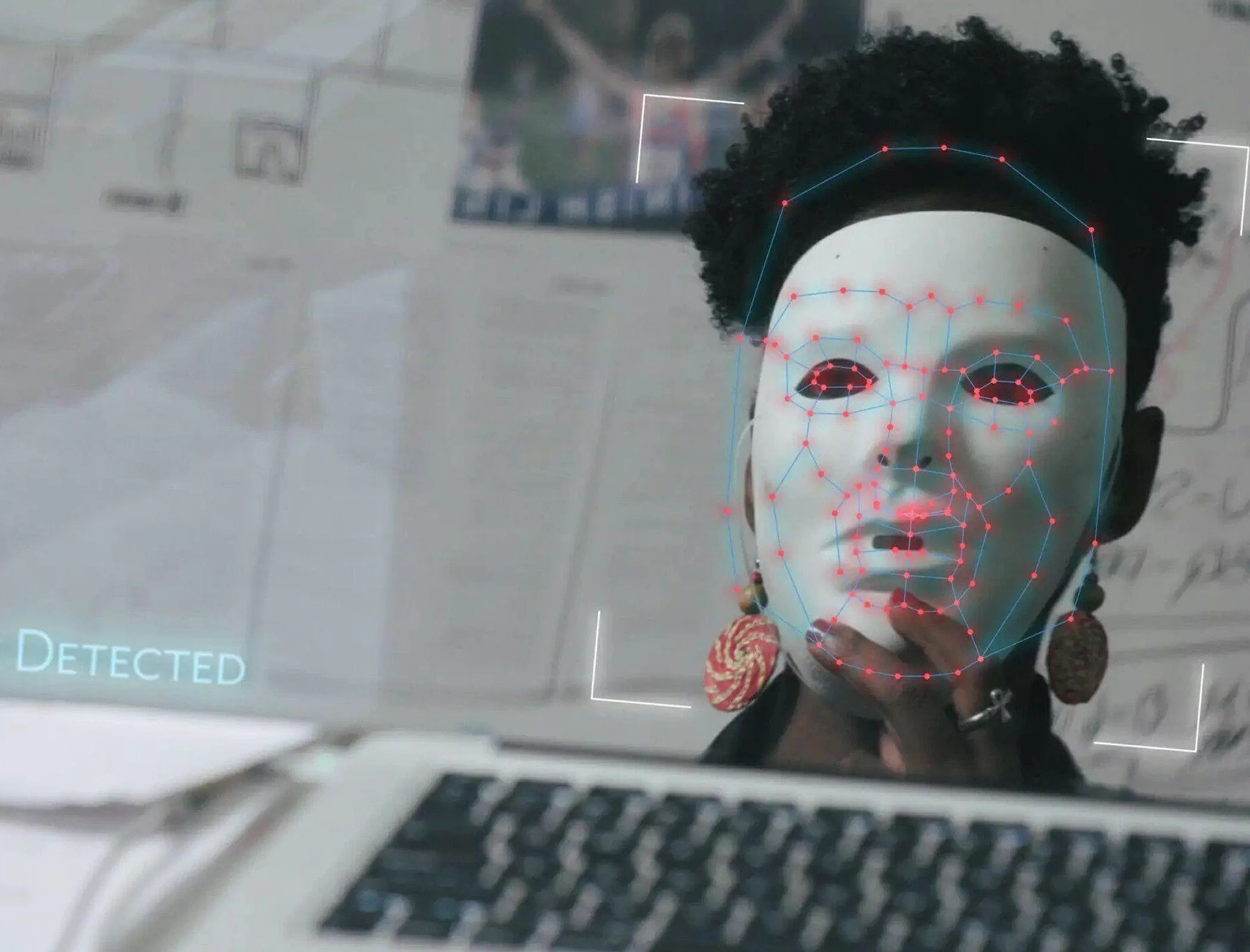

Más recientemente, ha habido problemas relacionados con la evidencia de prejuicios raciales dentro de los algoritmos de visión por computadora utilizados por los sistemas de reconocimiento facial, incluidos algunos que han llegado a juicios avanzados e incluso han sido implementados por las fuerzas del orden. Los defectos van desde la identificación errónea hasta el simple hecho de no reconocer e identificar a las personas con tonos de piel más oscuros. Están documentados a fondo en el documental de Netflix «Coded Bias», que se centra principalmente en el trabajo de la científica del MIT Media Lab, Joy Buolamwini, fundadora de la Algorithmic Justice League. Más notablemente, han atraído la atención mundial entre los asuntos planteados por el movimiento Black Lives Matter después del asesinato de George Floyd.

Sin embargo, las tensiones en torno a la inteligencia artificial y la ética y los riesgos en el lanzamiento de tecnología que no está lo suficientemente madura o no está debidamente probada (y, por lo tanto, vulnerable al diagnóstico de Kranzberg) realmente se convirtieron en noticias por derecho propio en diciembre pasado, cuando Timnit Gebru, codirector técnico de Ethical de Google Equipo artificial, dimitido. Su partida fue seguida en febrero de 2021 por el despido de la otra co-líder, Margaret Mitchell. Ambas mujeres son muy respetadas en el mundo de la IA y la ética.

Gebru dice que renunció debido a la insistencia inicial de Google de que eliminara su nombre y el de todos sus empleados de un documento técnico, «Sobre los peligros de los loros estocásticos», y la posterior negativa a decir por qué y quién había presentado objeciones.

Mitchell, quien junto con Gebru era un gran defensor de la diversidad dentro de Google y también se había pronunciado sobre las restricciones de publicación, fue, según Google, despedido por infringir las políticas de seguridad y el código de conducta de la empresa.

El documento levanta banderas sobre los modelos a escala masiva (desde BERT hasta Switch-C) que ahora están demostrando ser cada vez más populares en el procesamiento del lenguaje natural, y establece cuatro áreas principales de preocupación.

Estos incluyen la posibilidad de que los modelos sean tan grandes como para ser inmanejables, permitiendo así que los elementos de prejuicio racial, de género y de otro tipo pasen desapercibidos, y que los costos energéticos y ambientales de los modelos de capacitación de eso también puedan superar su impacto. beneficios, mientras que las estrategias alternativas no reciben suficiente atención. Aquellos que deseen profundizar en el documento y su contexto pueden ver el video a continuación para ver la presentación completa de la coautora, la profesora Emily M. Bender, cortesía del canal de YouTube del Instituto Alan Turing.

El escándalo, y fuera de Google, pocos en la comunidad de inteligencia artificial y ética lo consideran otra cosa, con Gebru y Mitchell al mando del apoyo total, ha puesto en primer plano toda una serie de problemas en torno al tema.

El artículo en sí fue descrito por un académico de alto nivel como «una serie de conclusiones no inesperadas o especialmente controvertidas basadas en la dirección que ha tomado la investigación», e incluso Google parece haber estado dispuesto a ver su publicación siempre que esos nombres fueran eliminados.

Con lo que impulsó las decisiones que provocaron las salidas aún no está claro (o al menos sujeto a cuestionamiento), la comunidad de inteligencia artificial ha visto el aumento de creencias de que el incidente es indicativo de tensiones peligrosas entre los líderes del equipo de productos de Google y sus investigadores de inteligencia artificial (acelerando el riesgo). de las preocupaciones ‘a escala’ de Kranzberg), que nuevamente resalta la tóxica ‘cultura de hermanos’ de Silicon Valley y el desprecio que la acompaña por la diversidad étnica y de género, y que, a pesar de todos sus enormes recursos financieros y técnicos, Google simplemente no podía manejar las tecnologías que tiene. invirtió mucho en los aspectos ecológicos de su propiedad de enormes granjas de servidores sujetas a escrutinio y críticas internas. Bien podría ser «todo lo anterior».

En un nivel, Parrotmuzzle muestra cómo los problemas dentro de los reinos de la IA y la ética se extienden más allá del dilema establecido en la ley de Kranzberg. Específicamente, ¿cómo se puede esperar que una empresa implemente tecnologías de manera ética, si su propia conducta y cultura parecen no cumplir con lo que ahora se considera, en Occidente, al menos, normas éticas razonables? Debe decirse que Google no es el único gigante tecnológico al que se le ha hecho esta pregunta recientemente.

También ilustra un punto de encuentro potencialmente valioso entre la ética, un tema demasiado amplio para cubrir aquí por completo, y las regulaciones y costumbres que los gobiernos y una parte cada vez mayor de la sociedad civil están buscando.

Por ejemplo, puede interpretar que el documento plantea la necesidad de realizar pruebas de estrés en los conjuntos de datos, tanto en sí mismos como por sí mismos y frente a otros formatos posibles. Eso comienza a describir un camino hacia la promoción de las mejores prácticas (siempre también una forma útil de autorregulación de la industria), así como la creación formal de puntos de referencia que deberían garantizar que una IA liberada para su uso satisfaga la debida diligencia regulatoria. Ciertamente, muchos investigadores de IA señalan que los conjuntos de datos que se utilizan ahora a menudo exigen mucho más examen de lo que se puede suponer inicialmente y, lo que es más importante, mucho más de lo que reciben.

Ya se considera que el mundo más amplio de la investigación sobre la ética de la IA ha influido en la regulación, y la Ley de Inteligencia Artificial de la UE es uno de los ejemplos más recientes. Establece cuatro niveles de riesgo: «Inaceptable», «Alto», «Limitado», «Mínimo». En la categoría «inaceptable» se encuentran, al menos para los europeos, conceptos como el uso de la inteligencia artificial para la puntuación social, la manipulación y la vigilancia (excluyendo la aplicación de la ley). En esta categoría, la ética obviamente ha tenido una gran influencia, pero en la categoría «alta» se requiere demasiado cuidado con las identificaciones biométricas, la educación y la capacitación, el acceso al empleo y más.

¿Es esto realmente tanto como la ética puede o debería insertar en el proceso de creación de un nuevo mundo centrado en la IA?

En última instancia, todo esto está sucediendo a un nivel muy alto y también tiende a imponer una construcción utilitaria a una disciplina que está evolucionando y, en su necesidad de explorar y confirmar normas sociales, necesariamente amorfa. En respuesta a un análisis reciente del Pew Research Center sobre IA ética, Barry Chudakov, director de Sertain Research y uno de los principales comentaristas de la actualidad sobre la intersección entre tecnología y conciencia, dijo: “Nuestro libro de ética está a medio escribir. Si bien no sugerimos que nuestros marcos éticos existentes no tengan valor, faltan páginas y capítulos «.

Ese mismo proyecto de Pew encontró que en una encuesta que ciertamente parece haber estado más limitada a lo bueno y lo bueno que a una muestra científica, solo el 32 por ciento de los encuestados creía que “los principios éticos centrados principalmente en el bien público se emplearán en la mayoría de los casos. Sistemas de IA para 2030 ”; El 68 por ciento no lo hizo.

Eso no se debió simplemente a observaciones más filosóficas como la de Chudakov. En una respuesta escrita, Mike Godwin, famoso por la Ley de Godwin y ex consejero general de la Fundación Wikimedia, hizo algunas observaciones familiares preocupantes. “El resultado más probable, incluso ante el aumento de las discusiones públicas y las convocatorias sobre la IA ética, será que los gobiernos y las políticas públicas tardarán en adaptarse. Los costos de las tecnologías impulsadas por la inteligencia artificial seguirán disminuyendo, lo que hará que sea más probable la implementación antes de las garantías de privacidad y otras salvaguardas éticas ”, escribió.

“El escenario más probable es que salga a la luz algún tipo de abuso público de las tecnologías de IA, y esto desencadenará limitaciones reactivas en el uso de la IA, que serán restricciones categóricas de instrumentos contundentes sobre su uso o (más probablemente) una mosaico de limitaciones éticas particulares dirigidas a casos de uso particulares, con un uso irrestricto que ocurre fuera de los márgenes de estas limitaciones «.

La ironía aquí es que, por mucho que la Primera Ley de Kranzberg sea útil como un dispositivo para indicar por qué las valoraciones éticas de la IA deben llevarse a cabo ahora y actuar sobre ellas mientras la tecnología todavía está en una relativa infancia, y hay indicios de que está sucediendo, lo es. una «ley» precisamente porque expresa algo que ha sucedido repetidamente a lo largo de la historia de la tecnología.

La observación de Godwin y las experiencias de Gebru y Mitchell sugieren que será una ley difícil de romper, aunque el esfuerzo bien podría valer la pena. Entonces, tal vez también deberíamos recordar la cuarta ley de Kranzberg: «Aunque la tecnología podría ser un elemento primordial en muchos asuntos públicos, los factores no técnicos tienen prioridad en las decisiones de política tecnológica».